I Large Language Model nella sicurezza fisica

L'AI offre un enorme potenziale di automazione e risparmio, ma è abbastanza sicura? Scopri come l'intelligenza artificiale si sta evolvendo nel nostro settore.

L'avvento dei Large Language Model (LLM) ha avuto un impatto enorme. A pochi mesi dal lancio, ChatGPT aveva raggiunto oltre 100 milioni di utenti, rendendo il chatbot AI di OpenAI l'applicazione consumer con la crescita più rapida mai registrata.

E non c'è da stupirsi. Gli LLM possono fare quasi di tutto: dal rispondere a domande e spiegare argomenti complessi a redigere sceneggiature cinematografiche complete e persino a scrivere codici. Di conseguenza, il mondo si è dimostrato allo stesso tempo entusiasta e preoccupato per le capacità di questa tecnologia AI.

Sebbene di recente gli LLM siano diventati un argomento di attualità, questa tecnologia esiste da molto tempo. Tuttavia, i recenti progressi degli LLM e di altri strumenti di intelligenza artificiale stanno creando nuove opportunità di automazione per svariati settori. Per questo motivo, è essenziale avere una conoscenza approfondita dei limiti dell'AI e dei potenziali rischi associtati.

Chiarimenti terminologici

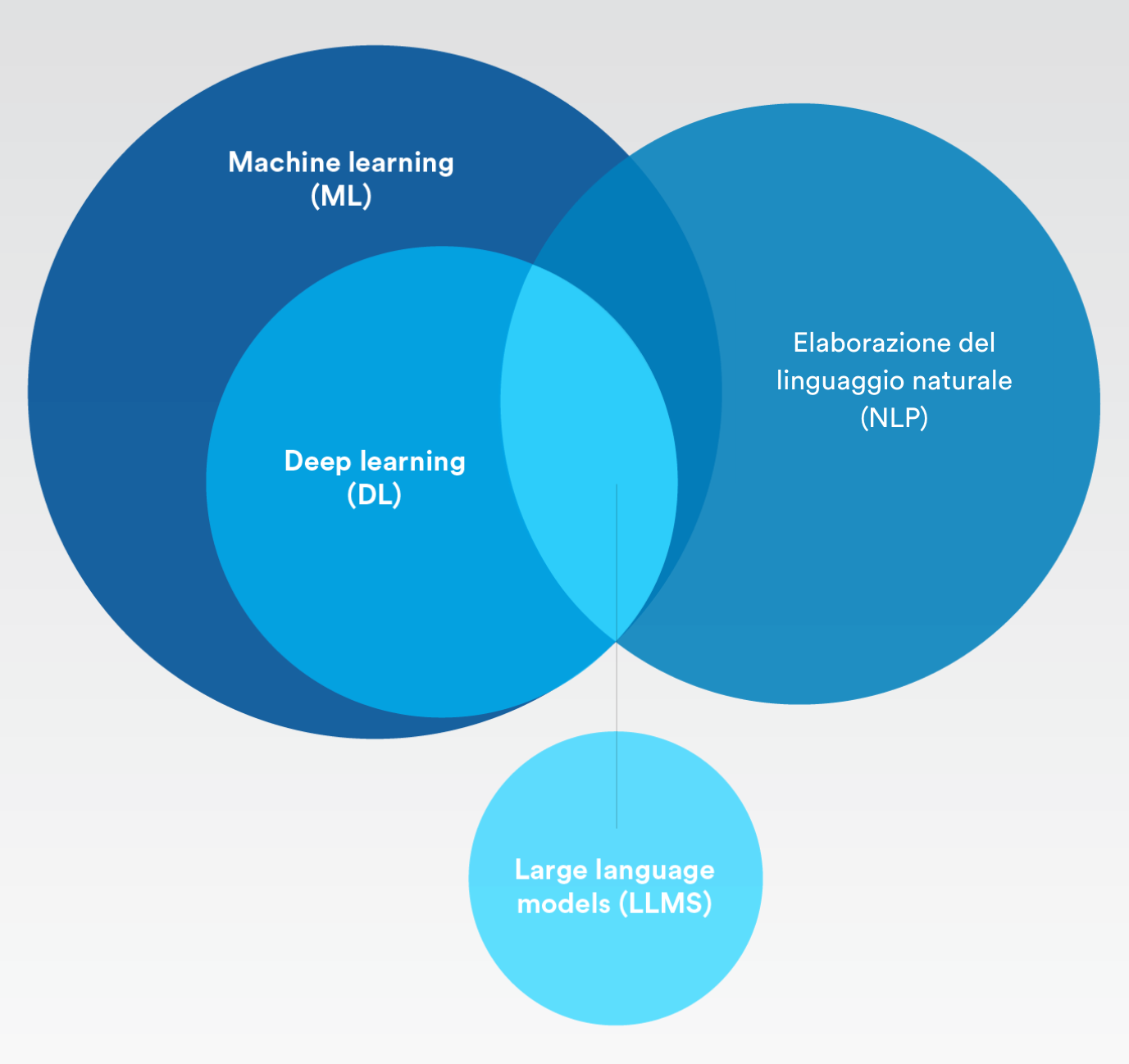

Intelligenza artificiale, machine learning, deep learning... Quali sono le differenze? E qual è il ruolo dei Large Language Model?

Intelligenza artificiale

L’abilità che le macchine intelligenti hanno di simulare l'intelligenza umana.In poche parole, sia il machine learning che il deep learning rientrano nella categoria dell'intelligenza artificiale.

Machine learning

Una branca dell'intelligenza artificiale che si occupa di creare sistemi per apprendere e adattarsi con un'interferenza umana minima.

Elaborazione del linguaggio naturale

La capacità dei modelli di apprendimento di comprendere il linguaggio umano e di eseguire compiti ripetitivi come il controllo ortografico, le traduzioni e la sintesi.

Deep learning

Un sottoinsieme del Machine learning che utilizza reti neurali artificiali per imitare il processo di apprendimento del cervello umano.

Large Language Model

Modelli di AI che utilizzano algoritmi di deep learning e grandi insiemi di dati provenienti da Internet.

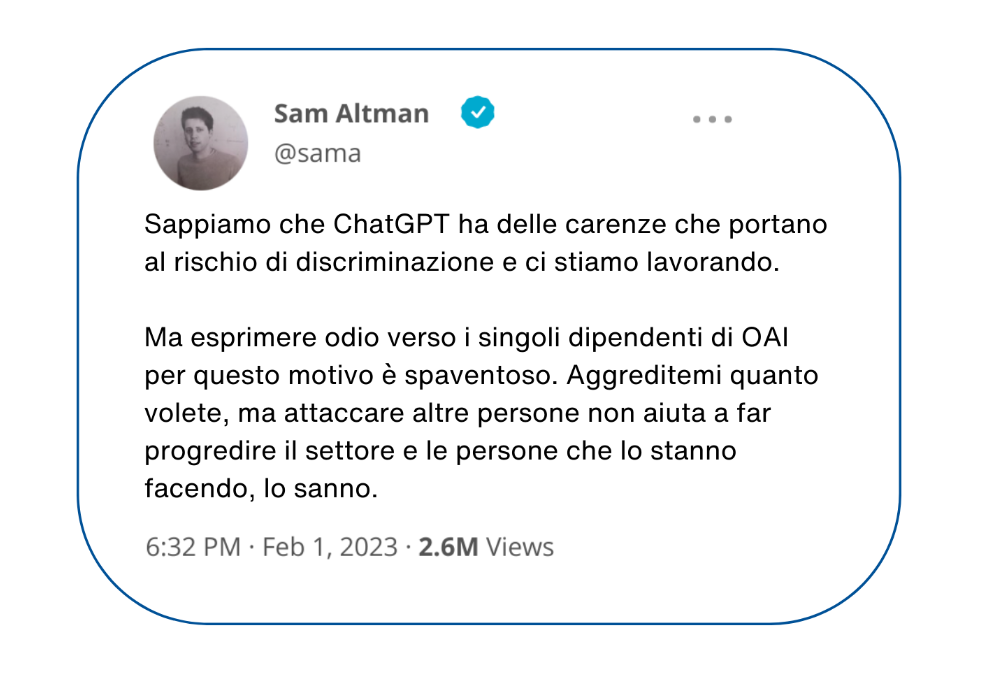

Rischi associati ai Large Language Model

All'inizio di quest'anno, Sam Altman, CEO di OpenAI, ha ammesso di aver riscontrato dei problemi legati al rischio di discriminazione che hanno messo in discussione ChatGPT. Più di recente, i ricercatori hanno scoperto che convincere i Large Language Model ad assumere identità di "persona cattiva" o addirittura di "figura storica" genera un aumento di sei volte nelle risposte tossiche e dannose del modello di machine learning.

I Large Language Model sono sicuri? Quando si valutano i rischi degli LLM, è importante considerare questo aspetto: la prima priorità dei Large Language Model è soddisfare l'utente. Non solo, gli LLM utilizzano anche un metodo di addestramento AI non supervisionato per alimentarsi con un ampio pool di dati casuali provenienti da Internet. Questo significa che le risposte che danno non sono sempre accurate, veritiere o prive di pregiudizi. Nel contesto della sicurezza, questo può diventare estremamente pericoloso.

Infatti, questo metodo non supervisionato ha aperto le porte a quelle che vengono definite "allucinazioni dell'AI". In poche parole, è quello che accade quando un modello di intelligenza artificiale genera risposte che sembrano plausibili, ma non sono reali nè basate su dati reali.

Gli LLM possono anche creare seri rischi per la privacy e la riservatezza. Un modello potrebbe essere stato addestrato su dati che contengono informazioni riservate su persone e aziende. E poiché ogni prompt di testo viene utilizzato per addestrare la versione successiva, chi richiede all'LLM un contenuto simile potrebbe venire a conoscenza di quelle informazioni sensibili attraverso le risposte del chatbot.

Potenzialmente, esistono anche peggiori abusi legati a questa tecnologia. Ad esempio, i malintenzionati con conoscenze scarse o nulle di programmazione potrebbero chiedere a un chatbot AI uno script che sfrutti una vulnerabilità nota o richiedere un elenco di modi per violare applicazioni o protocolli specifici. Anche se si tratta di esempi ipotetici, non possiamo fare a meno di chiederci come queste tecnologie potrebbero essere utilizzate in modi che non possiamo ancora prevedere.

Evoluzione dei Large Language Model nel settore della sicurezza fisica

Con la recente esplosione nella popolarità dei Large Language Model (LLM), c'è la sensazione che l'AI sia in grado di rendere magicamente tutto possibile. Ma non tutti i modelli AI sono uguali o avanzano allo stesso ritmo.

Large Language Model, deep learning e machine learning forniscono risultati basati sulla probabilità. Se diamo un'occhiata più da vicino ai Large Language Model, il loro obiettivo principale è fornire la risposta più plausibile a partire da un volume enorme e indiscriminato di dati. Come abbiamo visto, questo può portare a informazioni errate o ad allucinazioni dell'AI.

Nel settore della sicurezza fisica, gli algoritmi di machine learning e deep learning non si basano sull'AI generativa, che può inventare informazioni, ma sono progettati per classificare i dati e identificare modelli. Dal momento che si tratta comunque di risultati basati sulla probabilità, resta necessario un controllo da parte dell'essere umano per prendere una decisione finale su ciò che è vero o meno.

Lo stesso vale anche per tutti gli sbocchi positivi degli LLM. Per le applicazioni di sicurezza, potrebbe esistere un futuro in cui gli operatori potranno utilizzare un Language Model AI all'interno di una piattaforma di sicurezza per ottenere risposte rapide, ad esempio chiedendo "quante persone ci sono al terzo piano in questo momento" o "quanti badge per i visitatori abbiamo rilasciato il mese scorso". I modelli AI possono anche aiutare le aziende a creare criteri di sicurezza o a migliorare i dettagli dei protocolli di risposta.

Indipendentemente dal modo in cui vengono utilizzati i Language Model AI, una cosa è certa: per la sicurezza i modelli devono essere eseguiti in un ambiente più vincolato. Quindi, nonostante il recente grande entusiasmo per gli LLM, c'è ancora molto lavoro da fare perché diventino sicuri e adatti alle applicazioni di sicurezza fisica.

Implementazione dell'AI nel settore della sicurezza fisica

Nonostante di recente gli LLM siano stati catapultati al centro dell'attenzione, l'utilizzo dell'intelligenza artificiale nella sicurezza fisica non è una novità. Ci sono molti modi interessanti in cui l'AI supporta varie applicazioni.

Ecco alcuni casi d'uso attuali dell'AI nella sicurezza fisica:

Indagini più rapide

Scorrere i video di un determinato periodo di tempo per trovare tutti i filmati con un veicolo rosso.

Conteggio automatizzato delle persone

In un’ottica di miglioramento del servizio, ricevere un avviso sulle soglie di occupazione massima di un edificio o sapere quando le file dei clienti si stanno allungando troppo.

Rilevare le targhe dei veicoli

Rintracciare i veicoli attenzionati, ottimizzare i parcheggi dei dipendenti negli uffici o monitorare il flusso del traffico nelle città.

Migliorare la sicurezza informatica

Rafforzare la protezione antivirus sui dispositivi utilizzando il machine learning per identificare e bloccare le minacce informatiche conosciute e sconosciute sugli endpoint.

Per la maggior parte delle aziende, l'implementazione dell'AI si riduce a un paio di fattori trainanti: l'analisi di dati su larga scala e livelli di automazione più elevati. In un'epoca in cui tutti parlano di trasformazione digitale, le aziende vogliono sfruttare i propri dati e investimenti di sicurezza fisica per aumentare la produttività, migliorare le operation e ridurre i costi.

L'automazione può anche aiutare le aziende a rispettare i vari standard e regolamenti di settore, riducendo i costi della compliance. Il deep learning e il machine learning sono in grado di indicare agli operatori le informazioni più importanti e offrono un elevato potenziale di automazione dell'elaborazione dei dati e dei flussi di lavoro. In questo modo, è possibile rispondere più rapidamente alle interruzioni dell'attività e prendere decisioni migliori.

Nonostante la recente democratizzazione dell'AI attraverso svariate soluzioni di analisi video, esistono ancora molti miti su ciò che l'AI può o non può fare. Di conseguenza, per i professionisti della sicurezza fisica è importante capire che non tutte le soluzioni AI sono adatte a qualunque applicazione.

Automatizzare le attività o raggiungere un risultato desiderato è un processo di determinazione della fattibilità tecnica. Si tratta di identificare le soluzioni esistenti, le altre tecnologie che potrebbero essere necessarie e gli eventuali problemi di compatibilità da risolvere o altri fattori ambientali da considerare.

Anche una volta valutata la fattibilità, alcune aziende potrebbero chiedersi se il risultato giustifichi l'investimento. Quindi, anche se l'AI è un componente chiave per raggiungere livelli di automazione più elevati nel settore della sicurezza fisica, sono necessarie molte considerazioni, riflessioni e pianificazioni per ottenere risultati accurati.

In altre parole, è fondamentale procedere con cautela quando si esplorano nuove soluzioni AI e i risultati promessi devono essere valutati con spirito critico e due diligence.

Come sfruttare da subito l'AI nella sicurezza fisica

Le applicazioni basate sull'AI stanno progredendo in modi nuovi ed entusiasmanti. Sembrano offrire grandi opportunità alle aziende, aiutandole a raggiungere risultati specifici che aumentano la produttività, la sicurezza e la protezione a tutti i livelli.

Uno dei modi migliori per sfruttare i progressi dell'AI nel campo della sicurezza fisica è implementare una piattaforma di sicurezza aperta. Un'architettura aperta offre ai professionisti della sicurezza la libertà di esplorare svariate applicazioni di intelligenza artificiale e scegliere quelle in grado di apportare più valore alle loro operation. Man mano che le soluzioni AI arrivano sul mercato, è possibile provarle, spesso gratuitamente, e selezionare quelle più adatte agli obiettivi e all'ambiente applicativo.

Con l'emergere di nuove opportunità, emergono anche nuovi rischi. Ecco perché è altrettanto importante collaborare con aziende che danno priorità alla protezione dei dati, alla privacy e all'uso responsabile dell'AI. Oltre a migliorare la resilienza informatica e a promuovere una maggiore fiducia nei confronti dell'azienda, questo approccio dimostra anche la propria responsabilità sociale.

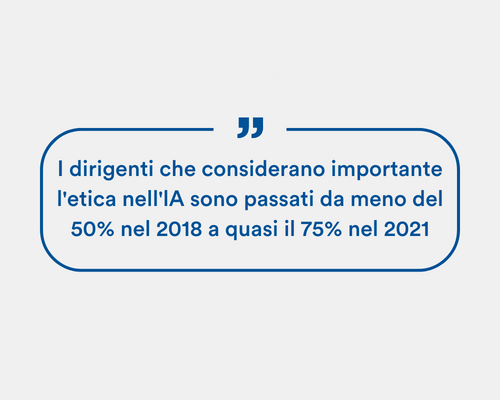

Nel rapporto "AI Ethics in Action" di IBM, l'85% dei consumatori ha dichiarato che è importante che le aziende tengano conto dell'etica quando utilizzano l'AI per affrontare i problemi della società. Il 75% dei dirigenti ritiene che un'etica dell'AI corretta possa distinguere un'azienda dalla concorrenza. Inoltre, oltre il 60% dei dirigenti ritiene che l'etica dell'AI aiuti le rispettive aziende a ottenere migliori risultati in materia di diversità, inclusione, responsabilità sociale e sostenibilità.

La posizione di Genetec sull'utilizzo responsabile dell'AI per la privacy e la governance dei dati

Dal momento che gli algoritmi di intelligenza artificiale possono elaborare grandi quantità di dati in modo rapido e accurato, l'AI sta diventando uno strumento sempre più importante per le soluzioni di sicurezza fisica. Ma, con l'evoluzione dell'AI, aumenta anche la sua capacità di utilizzare le informazioni personali in modi che possono interferire con la privacy.

I modelli AI possono anche produrre inavvertitamente decisioni o risultati distorti basati su vari pregiudizi, con un impatto negativo e, in ultima analisi, un rischio di discriminazione. Sebbene l'AI abbia il potere di rivoluzionare i modi di lavorare e di prendere decisioni, deve essere implementata responsabilmente.

Ecco perché, in Genetec™, diamo la massima priorità a un approccio responsabile all'AI. Infatti, per creare, migliorare e manutenere i nostri modelli AI, abbiamo elaborato una serie di principi guida che si basano su tre pilastri principali:

Privacy e governance dei dati

Privacy e governance dei dati

In qualità di provider tecnologico, ci assumiamo la responsabilità per il modo in cui utilizziamo l'AI nello sviluppo delle nostre soluzioni. Ciò significa che utilizziamo solo dataset che rispettano le normative vigenti in materia di protezione dei dati e, laddove possibile, anonimizziamo i dataset e utilizziamo dati sintetici. Inoltre, trattiamo i dataset con la massima cura e mettiamo la protezione dei dati e della privacy al primo posto in tutto ciò che facciamo.

Rispettiamo rigorose misure di autorizzazione e autenticazione per garantire che le persone sbagliate non possano accedere a dati e informazioni sensibili nelle nostre applicazioni AI. Ci impegniamo a fornire ai clienti strumenti built-in che li aiutino a rispettare a loro volta le normative sull'AI in continua evoluzione.

Trasparenza ed equità

Trasparenza ed equità

Quando sviluppiamo e utilizziamo modelli AI, pensiamo sempre a come minimizzare i pregiudizi. L'obiettivo è fare in modo che le nostre soluzioni forniscano sempre risultati equilibrati ed equi. Per garantirlo, testiamo rigorosamente i nostri modelli AI prima di condividerli con i clienti e lavoriamo sodo per migliorarne continuamente l'accuratezza e la sicurezza. Infine,

ci sforziamo per rendere i nostri modelli AI giustificabili. Di conseguenza, quando i nostri algoritmi AI prendono una decisione o forniscono un risultato, siamo in grado di spiegare ai clienti esattamente come sono arrivati a tale conclusione.

Decisioni umane

Decisioni umane

In Genetec, ci assicuriamo che i nostri modelli AI non possano prendere decisioni critiche in modo autonomo. Siamo convinti che un essere umano debba sempre essere coinvolto e avere l'ultima parola. Il motivo è che, in un contesto di sicurezza fisica, dare priorità al processo decisionale incentrato sulle persone è fondamentale. Pensiamo ad esempio a una situazione di vita o di morte, in cui gli esseri umani comprendono in modo innato i pericoli presenti e le azioni necessarie per salvare una vita. Le macchine non sono semplicemente in grado di interpretare le complessità degli eventi della vita reale, come farebbe un operatore

di sicurezza, quindi la risposta non può essere affidata esclusivamente a modelli statistici. Questo è anche il motivo per cui cerchiamo sempre di presentare i risultati dei modelli AI in modo che un essere umano possa fare le scelte più consapevoli. L'AI può offrire informazioni e approfondimenti, ma l'ultima parola deve sempre spettare a noi esseri umani.