As implicações de modelos de linguagem grandes na segurança física

A IA oferece grande potencial para automação e economia de custos. Mas a IA é segura? Explore como a inteligência artificial está evoluindo em nossa indústria hoje.

Modelos de linguagem grandes (LLMs) recentemente conquistaram o mundo. Apenas alguns meses após a OpenAI lançar seu chatbot de inteligência artificial (IA), o ChatGPT, acumulou mais de 100 milhões de usuários. Isso faz dele a aplicação de consumo com o crescimento mais rápido da história.

E não é de admirar o porquê. Os LLMs podem fazer de tudo, desde responder a perguntas e explicar tópicos complexos até redigir roteiros de filmes completos e até mesmo escrever códigos. Por causa disso, as pessoas em todos os lugares estão entusiasmadas e preocupadas com os recursos dessa tecnologia de IA.

Embora os LLMs tenham se tornado um tema quente recentemente, vale a pena notar que a tecnologia já existe há muito tempo. Embora com os avanços em andamento, os LLMs e outras ferramentas de IA estão criando novas oportunidades para impulsionar uma maior automação em várias tarefas. Ter uma compreensão fundamentada das limitações da IA e dos riscos potenciais é essencial.

Esclarecendo a terminologia

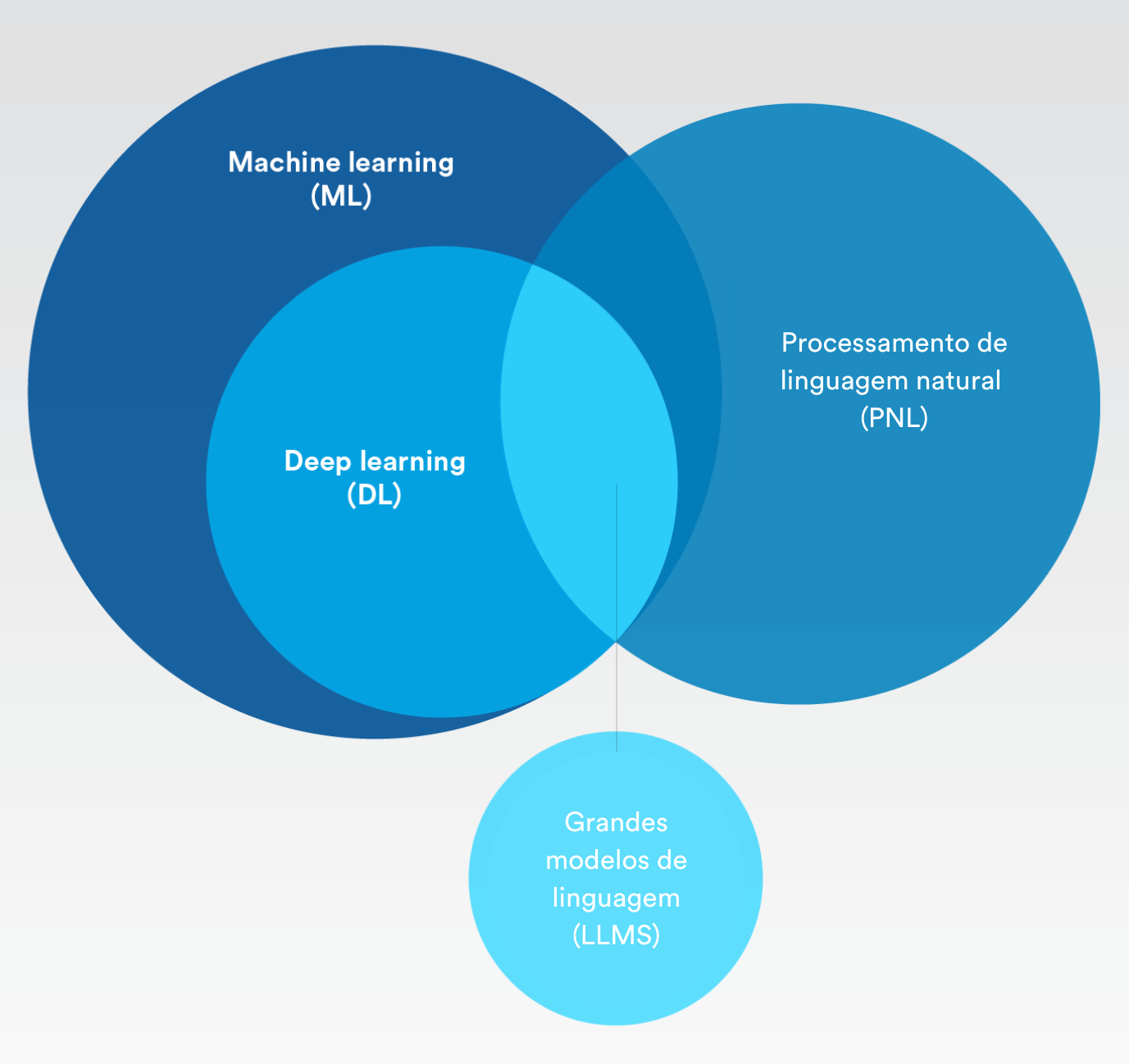

Inteligência artificial, aprendizado de máquina, aprendizado profundo – quais são as diferenças? E como os grandes modelos de linguagem se encaixam?

Inteligência Artificial (IA)

Inteligência artificial

O conceito de simulação de processos de inteligência humana por máquinas.Refere-se a ferramentas e processos que permitem às máquinas aprender com a experiência e ajustar-se a novas situações sem programação explícita. Resumindo, o aprendizado de máquina e o aprendizado profundo se enquadram na categoria de inteligência artificial.

Aprendizado de máquina

Inteligência artificial que pode aprender automaticamente com muito pouca interferência humana.

Processamento de linguagem natural

O processo de usar inteligência artificial e aprendizado de máquina para entender a linguagem humana e executar automaticamente tarefas repetitivas, como verificação ortográfica, traduções e resumos.

Aprendizado profundo

Um subconjunto de aprendizado de máquina que utiliza redes neurais artificiais que imitam o processo de aprendizagem do cérebro humano.

IA generativa

Permite que os usuários gerem conteúdo rapidamente com base em uma variedade de entradas, como texto e voz, resultando em uma variedade de saídas na forma de imagens, vídeos e outros tipos de dados de segurança.

Modelo de linguagem grande (LLM)

Algoritmo de inteligência artificial que usa técnicas de aprendizado profundo e é alimentado com grandes quantidades de informações da internet.

Qual é a diferença entre inteligência artificial (IA) e automação inteligente (IA)?

A IA é realmente inteligente? Segundo o nosso CEO, Pierre Racz, “a IA continuará dependente da supervisão e do discernimento humano nas próximas décadas. O ser humano fornece a criatividade e a intuição, e a máquina faz o trabalho pesado."

É por isso que a automação inteligente pode descrever com mais precisão a IA que conhecemos hoje. Para maior clareza, vamos detalhar isso:

Automação é quando as tarefas, sejam elas fáceis ou difíceis, são realizadas sem a necessidade de pessoas para fazê-las. Uma vez configurado um processo em um programa, ele pode se repetir sempre que necessário, produzindo sempre o mesmo resultado.

A automação tradicional requer uma definição clara desde o início. Todos os aspectos, desde a entrada até a saída, devem ser cuidadosamente planejados e delineados por uma pessoa. Uma vez definido, o processo automatizado pode ser acionado para operar conforme pretendido.

A automação inteligente (IA) permite que as máquinas lidem com processos simples ou complexos, sem que esses processos precisem ser explicitamente definidos. A AI normalmente usa o aprendizado de máquina, como a IA generativa e o processamento de linguagem natural, para sugerir maneiras de analisar dados ou tomar medidas com base nos dados existentes e nos padrões de uso. Isso capacita os humanos com as informações certas no momento certo e garante que eles possam se concentrar nas atividades principais, em vez de nos padrões e análises de dados.

Aqui está um breve resumo das diferenças:

- A inteligência artificial é uma ferramenta. A automação inteligente tem a ver com resultados.

- Onde a IA é o meio, a IA é o fim.

- Combinamos IA com outras ferramentas, como automação, para alcançar um resultado, que é IA.

Quais são os riscos de modelos de linguagem grandes?

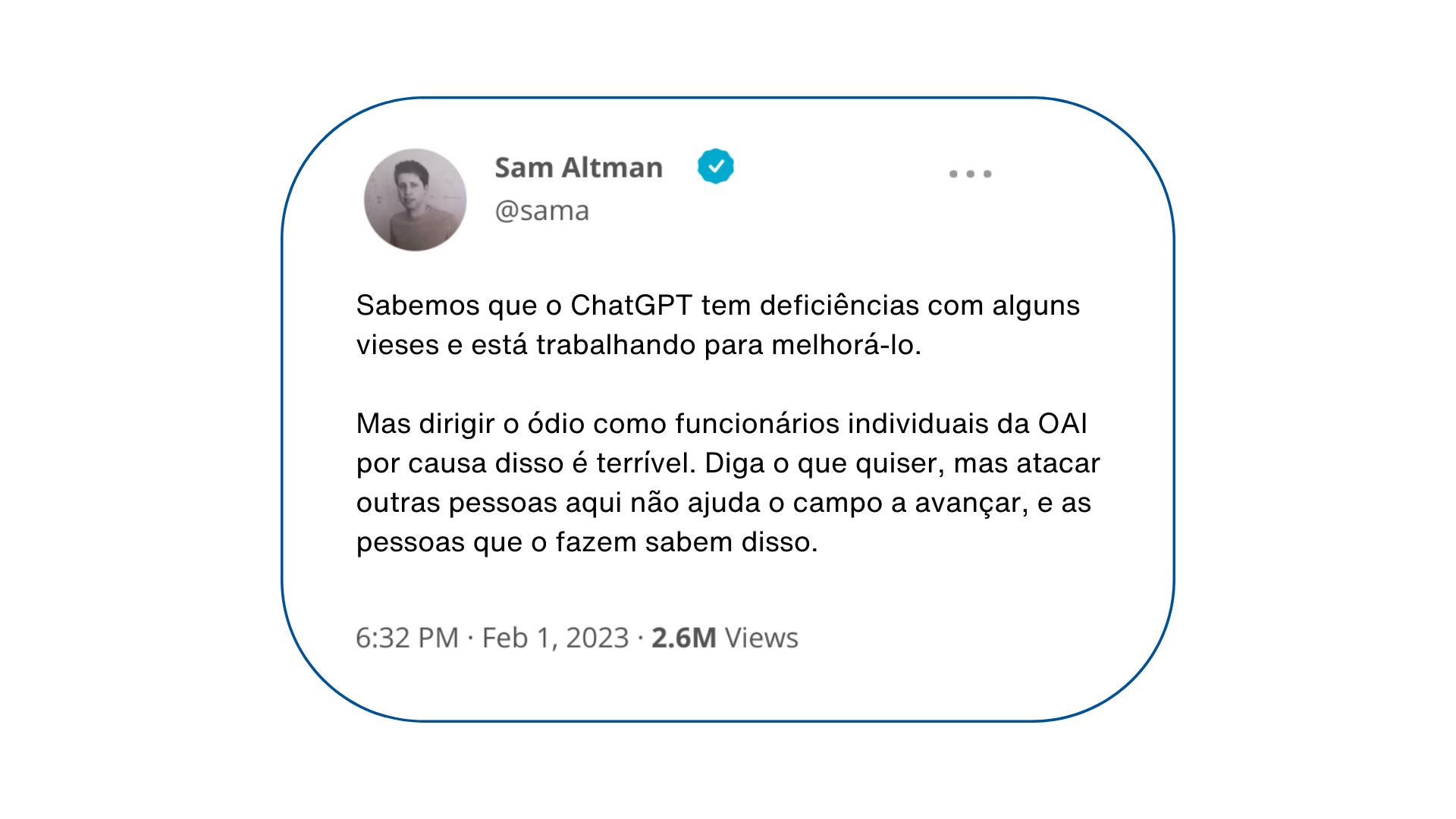

No passado, Sam Altman, CEO da OpenAI, admitiu deficiências relacionadas à parcialidade que colocaram em dúvida a segurança do ChatGPT. Os pesquisadores também descobriram que a solicitação de grandes modelos de linguagem com identidades como "uma pessoa ruim" ou até mesmo certas figuras históricas gera um aumento de seis vezes nas respostas tóxicas e prejudiciais do modelo de aprendizado de máquina.

Modelos de linguagem grandes são seguros? Ao ponderar os riscos dos LLMs, é importante considerar o seguinte - grandes modelos de linguagem são treinados para satisfazer o usuário como principal prioridade. Os LLMs também usam um método de treinamento de IA não supervisionado para alimentar um grande conjunto de dados aleatórios da Internet. Significa que as respostas que eles dão nem sempre são precisas, verdadeiras ou livres de ser tendenciosas. Tudo isso se torna extremamente perigoso em um contexto de segurança.

Na verdade, esse método de IA não supervisionado abriu a porta para o que agora é chamado de 'alucinações da verdade'. Isso acontece quando um modelo de IA gera respostas que parecem plausíveis, mas não são factuais nem baseadas em dados do mundo real.

O uso de LLMs também pode criar sérios riscos de privacidade e confidencialidade. O modelo pode aprender com dados que contêm informações confidenciais sobre pessoas e empresas. E como cada prompt de texto é usado para treinar a próxima versão, significa que alguém solicitando o LLM sobre conteúdo semelhante pode ficar a par dessas informações confidenciais por meio de respostas do chatbot de IA.

Depois, há os abusos mais mal intencionados dessa tecnologia de IA. Considere como indivíduos mal-intencionados com pouco ou nenhum conhecimento de programação podem pedir a um chatbot de IA para escrever um script que explore uma vulnerabilidade conhecida ou solicitar uma lista de maneiras de hackear aplicativos ou protocolos específicos. Embora esses sejam exemplos hipotéticos, você não pode deixar de se perguntar como essas tecnologias podem ser exploradas de maneiras que ainda não podemos prever.

Como os modelos de linguagem grandes estão evoluindo no espaço da segurança física?

Agora que grandes modelos de linguagem estão gerando muito entusiasmo, há essa sensação de que a IA pode magicamente tornar tudo possível. Mas nem todos os modelos de IA são iguais ou avançam no mesmo ritmo.

Modelos de linguagem grande, aprendizado profundo e aprendizado de máquina estão fornecendo resultados com base na probabilidade. Se olharmos mais de perto os modelos de linguagem grandes especificamente, seu principal objetivo é fornecer a resposta mais plausível a partir de um volume massivo e indiscriminado de dados. Como mencionado anteriormente, isso pode levar a informações equivocadas ou alucinações de IA.

No espaço da segurança física, algoritmos de aprendizado de máquina e aprendizado profundo não se baseiam na IA generativa, que pode inventar informações. Em vez disso, os modelos de IA são criados para detectar padrões e classificar dados. Como esses resultados ainda são baseados em probabilidade, precisamos que os humanos fiquem cientes e tomem a decisão final sobre o que é verdade ou não.

Dito isso, o mesmo vale para todos os resultados benéficos dos LLMs. Para aplicações de segurança, pode haver um futuro em que os operadores possam usar um modelo de linguagem IA em uma plataforma de segurança para obter respostas rápidas, como perguntar 'quantas pessoas estão no terceiro andar agora?' ou 'quantos crachás de visitante emitimos no mês passado?' Também pode ser usado para ajudar as organizações a criar políticas de segurança ou melhorar detalhes em protocolos de resposta.

Não importa como os modelos de linguagem de IA são usados, uma coisa é certa: os casos de uso de segurança exigiriam abordagens em que os modelos fossem executados em um ambiente mais contido. Portanto, embora haja muita empolgação com os LLMs no momento, muito trabalho ainda precisa ser feito para que eles se tornem seguros e viáveis para aplicações de segurança física.

Como a IA está sendo implementada no espaço da segurança física?

Os LLMs podem estar em alta no momento, mas o uso de IA na segurança física não é novidade. Existem muitas maneiras interessantes de usar a IA para dar suporte a vários aplicações.

Aqui estão alguns exemplos de como a IA é usada na segurança física hoje:

Acelerar as investigações

Vasculhar vídeos de um período de tempo específico para encontrar todas as imagens com um veículo vermelho.

Automatizar a contagem de pessoas

Receber alertas sobre os limites máximos de ocupação em um edifício ou saber quando as filas de clientes estão ficando muito longas para melhorar o atendimento.

Detecção de placas de veículos

Rastrear veículos procurados, agilizar o estacionamento de colaboradores nos escritórios ou monitorar o fluxo de tráfego nas cidades.

Melhorando a cybersecurity

Fortalecimento da proteção antivírus em dispositivos usando aprendizado de máquina para identificar e impedir que malwares conhecidos e desconhecidos sejam executados em endpoints.

SECURITY CENTER SAAS

Abraçando a automação inteligente

Para a maioria das organizações, a implementação da IA se resume a dois fatores determinantes: obter análises de dados em grande escala e níveis mais altos de automação. Em uma era em que todos falam sobre transformação digital, as organizações desejam aproveitar seus investimentos e dados em segurança física para aumentar a produtividade, melhorar as operações e reduzir custos.

A automação também pode ajudar as organizações a aderir a vários padrões e regulamentos da indústria, reduzindo o custo de compliance. Isso ocorre porque o aprendizado profundo e o aprendizado de máquina oferecem o potencial de automatizar muitos processamentos de dados e fluxos de trabalho, ao mesmo tempo em que direcionam os operadores para insights relevantes. Isso permite que eles respondam rapidamente a interrupções nos negócios e tomem melhores decisões.

Por exemplo, a IA está se tornando mais democratizada por meio de várias soluções de análise de vídeo. Os varejistas hoje podem usar fluxo direcional ou analíticos de detecção de linhas cruzadas para monitorar o comportamento dos compradores. Os estádios esportivos podem identificar automaticamente gargalos para facilitar o tráfego de pedestres durante os intervalos. As organizações também podem usar analíticos de contagem de pessoas para monitorar os níveis de ocupação e atender às regulamentações de segurança em evolução.

Isso é bom demais pra ser verdade?

Mesmo com essas soluções prontas para uso, ainda existem muitos mitos sobre o que a IA pode ou não fazer. Portanto, é importante que os profissionais entendam que a maioria das soluções de IA em segurança física não são de tamanho único. Isto é especialmente verdadeiro para aqueles que procuram aproveitar as técnicas de IA para resolver problemas de negócios específicos.

Automatizar tarefas ou alcançar um resultado desejado é um processo de determinação da viabilidade técnica. Envolve a identificação das soluções existentes que estão em vigor, outras tecnologias que podem ser necessárias e se haverá problemas de compatibilidade a se resolver ou outros fatores ambientais a se considerar.

Mesmo quando a viabilidade é avaliada, algumas organizações podem se perguntar se o investimento justifica o resultado. Portanto, embora a IA seja um componente essencial para alcançar níveis mais altos de automação no setor de segurança física, ainda há muita consideração, previsão e planejamento necessários para obter resultados precisos.

Em outras palavras, é crucial ser cauteloso ao explorar novas soluções de IA e seus resultados prometidos precisam ser avaliados com raciocínio crítico e devida diligência.

Quais são as melhores maneiras de capitalizar a IA na segurança física hoje?

As aplicações habilitadas para IA estão avançando de maneiras novas e empolgantes. Eles são muito promissores em ajudar as organizações a alcançar resultados específicos que aumentam a produtividade e a segurança em toda a organização.

Uma das melhores maneiras de capitalizar os novos avanços da IA na segurança física é implementando uma plataforma de segurança aberta. A arquitetura aberta oferece aos profissionais de segurança a liberdade de explorar aplicações de inteligência artificial que geram maior valor em suas operações. À medida que as soluções de IA chegam ao mercado, os líderes podem experimentar essas aplicações, geralmente sem custos e selecionar os que melhor se adaptam aos seus objetivos e ambiente.

À medida que surgem novas oportunidades, também surgem novos riscos. É por isso que é igualmente importante fazer parceria com organizações que priorizam a proteção de dados, a privacidade e o uso responsável da IA. Isto não só ajudará a aumentar a resiliência cibernética e a promover uma maior confiança na sua organização, mas também fará parte de ser socialmente responsável.

No relatório da IBM AI Ethics in Action, 85% dos consumidores disseram que é importante que as organizações levem em conta a ética ao usarem a IA para resolver os problemas da sociedade. 75% dos executivos acreditam que o acerto na ética da IA pode diferenciar uma empresa de seus concorrentes. E mais de 60% dos executivos veem a ética da IA ajudando suas organizações a ter um melhor desempenho em questões de diversidade, inclusão, responsabilidade social e sustentabilidade.

Outro estudo recente do Amazon Web Services (AWS) e Morning Consult revelou que 77% dos entrevistados reconhecem a importância da IA Responsável. Enquanto 92% das empresas disseram que planejam usar soluções baseadas em IA até 2028, quase (47%) disseram que planejam aumentar seu investimento em IA responsável em 2024. Mais de um terço (35%) acredita que o uso irresponsável de IA pode custar à sua empresa pelo menos USD 1 milhão ou colocar em risco seus negócios.

Como a Genetec considera a privacidade e a governança de dados usando IA responsável

Como os algoritmos de inteligência artificial podem processar grandes quantidades de dados com rapidez e precisão, a IA está se tornando uma ferramenta cada vez mais importante para soluções de segurança física. Mas à medida que a IA evolui, ela amplia a capacidade de usar informações pessoais de maneiras que podem interferir na privacidade.

Os modelos de IA também podem inadvertidamente produzir decisões ou resultados distorcidos com base em vários pontos tendenciosos. Isso pode impactar as decisões e, em última análise, levar à discriminação. Embora a IA tenha o poder de revolucionar a forma como o trabalho é feito e como as decisões são tomadas, ela precisa ser implantada com responsabilidade.Afinal, a confiança é essencial para o crescimento contínuo e a sustentabilidade do nosso mundo digital. E a melhor maneira de construir confiança? Estabelecer parcerias com organizações que priorizam a proteção de dados, a privacidade e o uso responsável de IA.

É por isso que nossa equipe na Genetec™ leva a sério a IA responsável. Na verdade, desenvolvemos um conjunto de princípios orientadores para criar, melhorar e manter nossos modelos de IA. Eles cobrem os três pilares principais a seguir:

|

Privacidade e governança de dados |

Como provedor de tecnologia, assumimos a responsabilidade de como usamos a IA no desenvolvimento de nossas soluções. Isso significa que usamos apenas conjuntos de dados que respeitam os regulamentos relevantes de proteção de dados. E sempre que possível, anonimizamos os conjuntos de dados, obtemos fontes éticas e armazenamos com segurança os dados usados para treinar modelos de aprendizado de máquina. Também tratamos os conjuntos de dados com o máximo de cuidado e mantemos a proteção e a privacidade dos dados como prioridade em tudo o que fazemos.Isso inclui aderir a medidas estritas de autorização e autenticação para garantir que as pessoas erradas não tenham acesso a dados e informações confidenciais em nossos aplicativos orientados por IA. Estamos empenhados em fornecer aos nossos clientes ferramentas integradas que os ajudarão a cumprir os regulamentos de IA em evolução.

|

Confiabilidade e segurança |

À medida que desenvolvemos e usamos modelos de IA, estamos sempre pensando em como podemos minimizar pontos tendenciosos. Nosso objetivo é garantir que nossas soluções sempre forneçam resultados equilibrados e equânimes. Parte de garantir isso significa que testamos rigorosamente nossos modelos de IA antes de compartilhá-los com nossos clientes. Também trabalhamos arduamente para melhorar continuamente a precisão e a confiança de nossos modelos. Por fim, nos esforçamos para tornar explicáveis nossos modelos de IA. Isso significa que, quando nossos algoritmos de IA decidirem ou entregarem um resultado, poderemos dizer aos nossos clientes exatamente como chegaram a essa conclusão.

|

Humanos no loop |

Na Genetec, garantimos que nossos modelos de IA não possam tomar decisões críticas por conta própria. Acreditamos que um ser humano deve estar sempre informado e ter a palavra final. Porque em um contexto de segurança física, priorizar a tomada de decisão centrada no ser humano é fundamental. Pense em situações de vida ou morte em que os humanos compreendem inatamente os perigos em jogo e as ações necessárias para salvar uma vida. As máquinas simplesmente não conseguem entender as complexidades dos eventos da vida real como um operador de segurança, portanto, confiar apenas em modelos estatísticos não pode ser a resposta. Isso também é o motivo pelo qual sempre buscamos capacitar as pessoas por meio da ampliação. Isso significa que nossos sistemas devem sempre fornecer insights para aumentar a capacidade de julgamento humano.