Auswirkungen großer Sprachmodelle auf die physische Sicherheit

KI bietet ein großes Potenzial für Automatisierung und Kosteneinsparungen. Aber ist KI sicher? Erfahren Sie, wie sich die künstliche Intelligenz in unserer Branche heute entwickelt.

Große Sprachmodelle (Large Language Models, LLMs) erobern im rasanten Tempo die Welt. Nur wenige Monate, nachdem OpenAI seinen auf künstlicher Intelligenz (KI) basierenden Chatbot ChatGPT auf den Markt gebracht hatte, gab es bereits über 100 Millionen Nutzer. Damit ist es die am schnellsten wachsende Verbraucheranwendung der Geschichte.

Und das ist auch kein Wunder. LLMs können vieles – von der Beantwortung von Fragen und der Erläuterung komplexer Themen bis hin zum Verfassen von Drehbüchern in voller Länge und dem Schreiben von Code. Daher sind Menschen weltweit sowohl begeistert als auch besorgt über das Potenzial dieser KI-Technologie.

Obwohl LLMs erst seit kurzem in aller Munde sind, gibt es diese Technologie schon seit langem. Angesichts der aktuellen Fortschritte eröffnen LLMs und andere KI-Tools jedoch neue Möglichkeiten für eine stärkere Automatisierung verschiedenster Abläufe. Ein fundiertes Verständnis der Grenzen und potenziellen Risiken von KI ist unerlässlich.

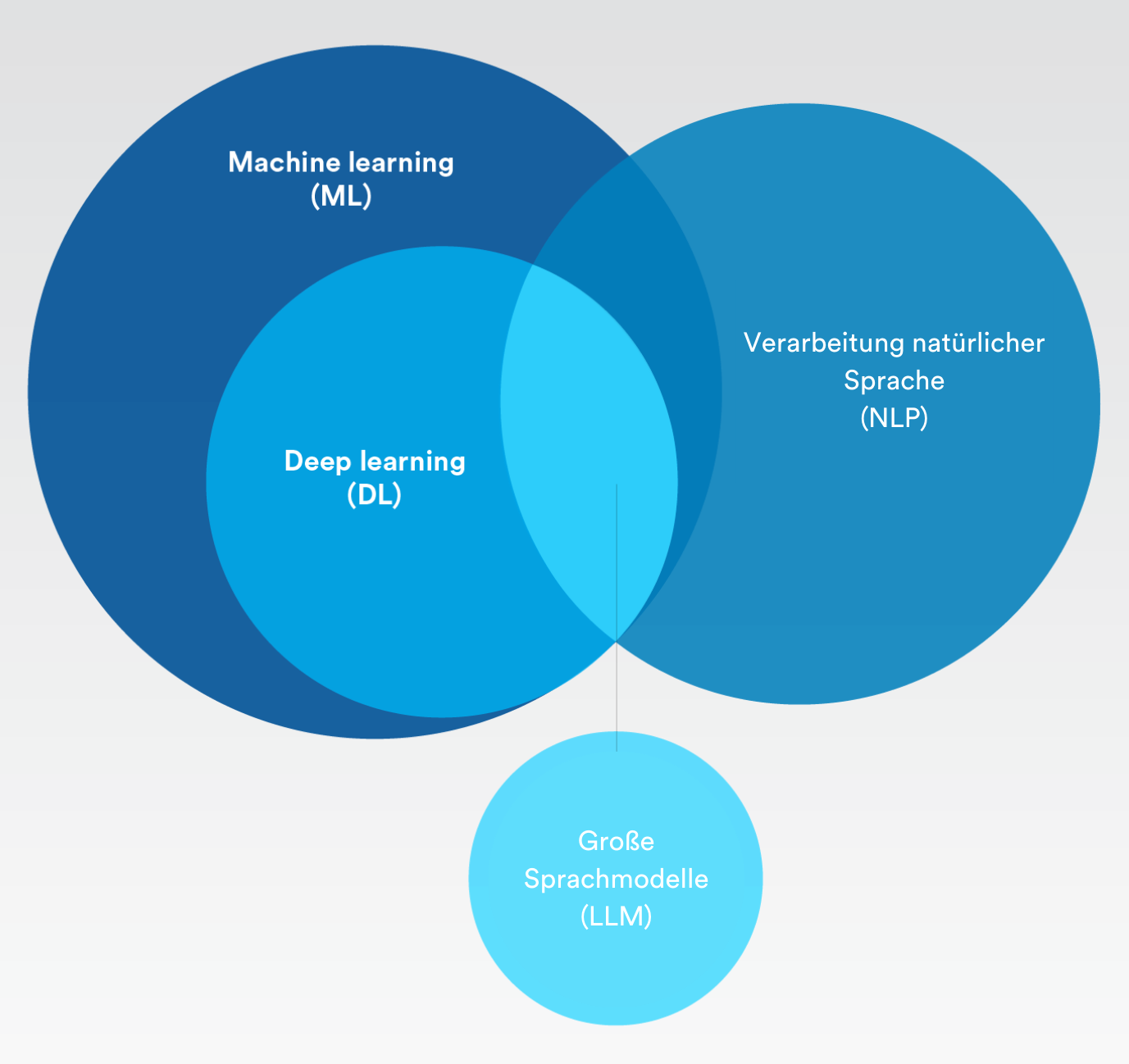

Begriffsklärung

Künstliche Intelligenz, maschinelles Lernen, Deep Learning – wo liegen die Unterschiede? Und was haben große Sprachmodelle damit zu tun?

Künstliche Intelligenz

Das Konzept der Simulation von Prozessen menschlicher Intelligenz durch Maschinen. Kurz gesagt: Maschinelles Lernen und Deep Learning fallen beide in die Kategorie der künstlichen Intelligenz.

Maschinelles Lernen

Künstliche Intelligenz, die sich mit sehr geringem menschlichen Eingriff automatisch anpassen kann.

Natürliche Sprachverarbeitung

Der Prozess, bei dem künstliche Intelligenz und maschinelles Lernen eingesetzt werden, um menschliche Sprache zu verstehen und repetitive Aufgaben wie Rechtschreibprüfung, Übersetzungen und Zusammenfassungen automatisch durchzuführen.

Deep Learning

Ein Teilbereich des maschinellen Lernens, in dem künstliche neuronale Netzwerke verwendet werden, die den Lernprozess des menschlichen Gehirns nachahmen.

Großes Sprachmodell

Algorithmus der künstlichen Intelligenz, der Deep-Learning-Techniken verwendet und mit riesigen Mengen an Informationen aus dem Internet gespeist wird.

Welche Risiken bergen große Sprachmodelle?

Zu Beginn dieses Jahres räumte Sam Altman, CEO von OpenAI, Defizite in Bezug auf Voreingenommenheit ein, die die Sicherheit von ChatGPT fragwürdig erscheinen ließen. Kürzlich stellten Forscher fest, dass die Aufforderung an große Sprachmodelle, Identitäten wie "eine schlechte Person" oder sogar bestimmte historische Persönlichkeiten zu nennen, zu einem sechsfachen Anstieg toxischer und schädigender Antworten seitens des maschinellen Lernmodells führt.

Sind große Sprachmodelle sicher? Beim Abwägen der Risiken von LLMs muss man bedenken, dass große Sprachmodelle in erster Linie darauf trainiert werden, den Benutzer zufrieden zu stellen. LLMs nutzen außerdem eine unüberwachte KI-Trainingsmethode, die sich aus einem großen Pool von Zufallsdaten aus dem Internet speist. Die Antworten, die sie geben, sind daher nicht immer genau, wahrheitsgetreu oder frei von Vorurteilen. In Bezug auf die Sicherheit ist all dies äußerst bedenklich.

Diese unbeaufsichtigte KI-Methode hat den Weg zu dem geebnet, was inzwischen als „Wahrheitshalluzinationen“ bezeichnet wird. Dazu kommt es, wenn ein KI-Modell Antworten generiert, die plausibel erscheinen, aber nicht den Tatsachen entsprechen oder auf realen Daten beruhen.

Die Verwendung von LLMs kann zudem ernsthafte Risiken für den Datenschutz und die Vertraulichkeit mit sich bringen. Das Modell kann aus Daten lernen, die vertrauliche Informationen über Personen und Unternehmen enthalten. Jede Textaufforderung wird wiederum verwendet, um die nächste Version zu trainieren. Wenn jemand das LLM zu ähnlichen Inhalten befragt, könnten dadurch vertrauliche Informationen über die KI-Chatbot-Antworten preisgegeben werden.

Hinzu kommen missbräuchliche Anwendungen dieser KI-Technologie. Angreifer mit geringen oder gar keinen Programmierkenntnissen könnten einen KI-Chatbot bitten, ein Skript zu erstellen, das eine bekannte Schwachstelle ausnutzt, oder eine Liste mit Möglichkeiten zum Hacken bestimmter Anwendungen oder Protokolle anfordern. Zwar handelt es sich hierbei um hypothetische Beispiele, dennoch stellt sich die Frage, wie diese Technologien auf eine Art und Weise genutzt werden könnten, die wir noch nicht vorhersehen können.

Wie entwickeln sich die großen Sprachmodelle im Bereich der physischen Sicherheit?

Angesichts des Hypes um große Sprachmodelle (Large Language Models, LLMs) entsteht der Eindruck, dass KI auf magische Weise alles möglich machen kann. Jedoch sind nicht alle KI-Modelle gleich oder entwickeln sich im gleichen Tempo weiter.

Große Sprachmodelle, Deep Learning und maschinelles Lernen liefern Ergebnisse, die auf Wahrscheinlichkeiten basieren. Wenn wir uns große Sprachmodelle genauer ansehen, besteht ihr Hauptziel darin, die plausibelste Antwort aus einer riesigen und wahllosen Datenmenge zu liefern. Dies kann, wie bereits erwähnt, zu Fehlinformationen oder KI-generierten Halluzinationen führen.

Im Bereich der physischen Sicherheit basieren die Algorithmen für maschinelles Lernen und Deep Learning nicht auf generativer KI, die Informationen erfinden kann. Stattdessen werden KI-Modelle entwickelt, um Muster zu erkennen und Daten zu klassifizieren. Da diese Ergebnisse dennoch auf Wahrscheinlichkeiten beruhen, müssen wir Menschen einbeziehen und die endgültige Entscheidung darüber treffen, was wahr ist und was nicht.

Allerdings gilt dies auch für alle anderen positiven Ergebnisse von LLMs. Bei Sicherheitsanwendungen könnte es in Zukunft möglich sein, ein KI-Sprachmodell innerhalb einer Sicherheitsplattform zu verwenden, um schnelle Antworten zu erhalten, beispielsweise auf die Frage „Wie viele Personen befinden sich gerade im 3. Stock?“ oder „Wie viele Besucherausweise haben wir letzten Monat ausgestellt?“. Auf diese Weise können Unternehmen auch Sicherheitsrichtlinien erstellen oder Details in Antwortprotokollen verbessern.

Unabhängig von der Nutzung von KI-Sprachmodellen ist eines sicher: Bei Sicherheitsanwendungen sind Ansätze erforderlich, bei denen die Modelle in einer geschlossenen Umgebung ausgeführt werden. Zwar herrscht derzeit viel Wirbel um LLMs, es muss jedoch noch viel getan werden, damit sie für Anwendungen im Bereich der physischen Sicherheit sicher und praktikabel werden.

Wie wird KI im Bereich der physischen Sicherheit eingesetzt?

LLMs sind zwar derzeit in aller Munde, aber der Einsatz von KI im Bereich der physischen Sicherheit ist nichts Neues. Es gibt viele interessante Möglichkeiten, wie KI zur Unterstützung verschiedener Anwendungen genutzt wird.

Hier sind einige Beispiele dafür, wie KI heute in der physischen Sicherheit verwendet wird:

Untersuchungen beschleunigen

Durchforstungsvideo eines bestimmten Zeitraums, um alle Aufnahmen mit einem roten Fahrzeug zu finden.

Personenzählung automatisieren

Sie werden auf maximale Belegungsschwellen in einem Gebäude hingewiesen oder wissen, wann die Kundenschlangen zu lang werden, um den Service zu verbessern.

Kennzeichen von Fahrzeugen erkennen

Verfolgen Sie gesuchte Fahrzeuge, optimieren Sie Mitarbeiterparkplätze in Büros oder überwachen Sie den Verkehrsfluss in Städten.

Cybersicherheit verbessern

Stärkung des Virenschutzes auf Appliances durch den Einsatz von maschinellem Lernen zur Erkennung und Blockierung bekannter und unbekannter Malware auf Endgeräten.

Für die meisten Unternehmen geht es bei der Implementierung von KI um zwei entscheidende Faktoren: umfangreiche Datenanalysen und einen höheren Grad an Automatisierung. Angesichts der digitalen Transformation, von der gerade alle sprechen, wollen Unternehmen ihre Investitionen in die physische Sicherheit und ihre Daten nutzen, um die Produktivität zu steigern, Betriebsabläufe zu verbessern und Kosten zu senken.

Die Automatisierung kann Unternehmen auch dabei helfen, verschiedene Industrienormen und Vorschriften einzuhalten und gleichzeitig die Kosten im Zusammenhang mit der Compliance zu senken. Denn Deep Learning und maschinelles Lernen bieten das Potenzial, einen Großteil der Datenverarbeitung und der Arbeitsabläufe zu automatisieren und gleichzeitig den Anwendern relevante Erkenntnisse zu vermitteln. So können sie schnell auf betriebliche Störungen reagieren und bessere Entscheidungen treffen.

Und obwohl KI durch verschiedene Videoanalyselösungen immer weiter verbreitet wird, gibt es immer noch viele Mythen darüber, wozu KI fähig ist und wozu nicht. Daher müssen Sicherheitsfachleute begreifen, dass die meisten KI-Lösungen für die physische Sicherheit keine Einheitslösungen sind.

Um Aufgaben zu automatisieren oder ein gewünschtes Ergebnis zu erzielen, muss die technische Durchführbarkeit bestimmt werden. Dabei müssen die vorhandenen Lösungen, andere eventuell benötigte Technologien und etwaige Kompatibilitätsprobleme oder andere Umweltfaktoren ermittelt werden.

Selbst nachdem die Machbarkeit geprüft wurde, fragen sich manche Organisationen, ob die Investition das Ergebnis rechtfertigt. Obwohl KI eine Schlüsselrolle bei der Erreichung eines höheren Automatisierungsgrades in der physischen Sicherheitsbranche spielt, bedarf es noch viel Überlegungen, Voraussicht und Planung, um genaue Ergebnisse zu erzielen.

Mit anderen Worten: Bei der Einführung neuer KI-Lösungen ist Vorsicht geboten, wobei die versprochenen Ergebnisse kritisch und sorgfältig abzuwägen sind.

Wie lässt sich KI heute am besten für die physische Sicherheit nutzen?

KI-gestützte Anwendungen entwickeln sich auf neue und faszinierende Weise weiter. Sie bieten vielversprechende Möglichkeiten, um Unternehmen dabei zu helfen, spezifische Ergebnisse zu erzielen, die die Produktivität, Sicherheit und den Schutz im gesamten Unternehmen erhöhen.

Die Implementierung einer offenen Sicherheitsplattform ist eine hervorragende Methode, um von den neuen KI-Fortschritten in der physischen Sicherheit zu profitieren. Dank der offenen Architektur haben Sicherheitsexperten die Freiheit, Anwendungen mit künstlicher Intelligenz zu erproben, die einen größeren Nutzen für ihre Abläufe bringen. Mit der Markteinführung von KI-Lösungen können Entscheidungsträger diese Anwendungen oft kostenlos testen und diejenigen auswählen, die am besten zu ihren Zielen und ihrer Umgebung passen.

Mit neuen Chancen ergeben sich auch neue Risiken. Daher ist es genauso wichtig, mit Organisationen zusammenzuarbeiten, die den Datenschutz, die Privatsphäre und den verantwortungsvollen Einsatz von KI in den Vordergrund stellen. Dadurch lassen sich nicht nur die Cyber-Resilienz verbessern und das Vertrauen in Ihr Unternehmen stärken – es ist auch ein Teil Ihrer sozialen Verantwortung.

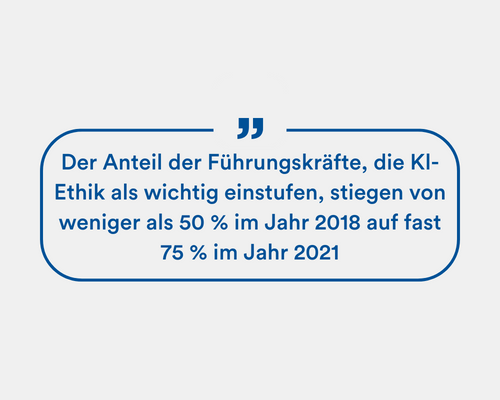

In dem IBM-Bericht mit dem Titel „AI Ethics in Action“ (KI-Ethik in Aktion) gaben 85 % der Verbraucher an, dass es für Unternehmen wichtig ist, beim Einsatz von KI zur Bewältigung gesellschaftlicher Probleme ethische Aspekte zu berücksichtigen. 75 % aller Führungskräfte sind der Auffassung, dass sich ein Unternehmen von der Konkurrenz abheben kann, wenn es ethische Gesichtspunkte bei der Nutzung von KI richtig einbezieht. Mehr als 60 % der Führungskräfte sind außerdem der Meinung, dass KI-Ethik ihren Unternehmen zu einer besseren Leistung in den Bereichen Vielfalt, Integration, soziale Verantwortung und Nachhaltigkeit verhilft.

So setzt Genetec Datenschutz und Data Governance mit verantwortungsvoller KI um

Da Algorithmen der künstlichen Intelligenz (KI) große Datenmengen schnell und präzise verarbeiten können, gewinnt KI als Instrument für physische Sicherheitslösungen zunehmend an Bedeutung. Doch mit der Weiterentwicklung der KI steigt auch das Risiko, dass personenbezogene Daten in einer Weise genutzt werden, die die Privatsphäre verletzen kann.

KI-Modelle können außerdem unbeabsichtigt verzerrte Entscheidungen oder Ergebnisse liefern, die auf verschiedenen Vorurteilen beruhen. Das kann Entscheidungen beeinflussen und letztlich zu Diskriminierung führen. KI besitzt zwar das Potenzial, die Erledigung von Aufgaben und die Entscheidungsfindung zu revolutionieren, doch muss sie verantwortungsvoll eingesetzt werden.

Deshalb nimmt unser Team bei Genetec™ verantwortungsvolle KI ernst. Wir haben eine Reihe von Leitprinzipien für die Erstellung, Verbesserung und Verwaltung unserer KI-Modelle entwickelt. Diese beruhen auf den folgenden drei Grundpfeilern:

Datenschutz und Data Governance

Datenschutz und Data Governance

Als Technologieanbieter übernehmen wir die Verantwortung dafür, wie wir KI bei der Entwicklung unserer Lösungen einsetzen. Daher verwenden wir nur Datensätze, die den einschlägigen Datenschutzbestimmungen entsprechen. Soweit möglich, anonymisieren wir Datensätze und verwenden synthetische Daten. Außerdem behandeln wir Datensätze mit äußerster Sorgfalt und achten bei allem, was wir tun, auf Datenschutz und Privatsphäre.

Dazu gehört auch die Einhaltung strenger Autorisierungs- und Authentifizierungsmaßnahmen, um sicherzustellen, dass Unbefugte keinen Zugriff auf sensible Daten und Informationen in unseren KI-gesteuerten Anwendungen erhalten. Unser Ziel ist es, unseren Kunden integrierte Tools zur Verfügung zu stellen, die sie bei der Einhaltung der sich weiterentwickelnden KI-Vorschriften unterstützen.

Transparenz und Fairness

Transparenz und Fairness

Bei der Entwicklung und Verwendung von KI-Modellen überlegen wir stets, wie wir Voreingenommenheit minimieren können. Unser Ziel ist es, sicherzustellen, dass unsere Lösungen stets ausgewogene und faire Ergebnisse liefern. Dazu gehört auch, dass wir unsere KI-Modelle rigoros testen, bevor wir sie unseren Kunden zur Verfügung stellen. Wir setzen außerdem alles daran, die Genauigkeit und das Vertrauen in unsere Modelle ständig zu verbessern. Schließlich wollen

wir unsere KI-Modelle nachvollziehbar gestalten. Das heißt, wenn unsere KI-Algorithmen eine Entscheidung treffen oder ein Ergebnis liefern, können wir unseren Kunden genau darlegen, wie der Algorithmus zu diesem Ergebnis gekommen ist.

Von Menschen getroffene Entscheidungen

Von Menschen getroffene Entscheidungen

Bei Genetec stellen wir sicher, dass unsere KI-Modelle keine kritischen Entscheidungen allein treffen können. Wir sind der Überzeugung, dass ein Mensch immer dabei sein und das letzte Wort haben sollte. Denn im Kontext der physischen Sicherheit ist es von entscheidender Bedeutung, dass der Mensch im Mittelpunkt der Entscheidungsfindung steht. Es gibt Situationen, in denen es um Leben und Tod geht, in denen Menschen die Gefahren erkennen und wissen, welche Maßnahmen erforderlich sind, um ein Leben zu retten. Maschinen können die Feinheiten realer Ereignisse einfach nicht so gut erfassen wie ein Sicherheitsmitarbeiter,

weshalb es nicht ausreicht, sich ausschließlich auf statistische Modelle zu verlassen. Das ist auch der Grund, warum wir uns stets bemühen, die Ergebnisse der KI-Modelle so zu präsentieren, dass ein Mensch möglichst fundierte Entscheidungen treffen kann. KI kann Erkenntnisse liefern, aber Menschen sollten immer die Entscheidungsträger sein.