Les répercussions des grands modèles de langage dans le secteur de la sécurité physique

L’IA offre un énorme potentiel en termes d’automatisation et d’économies. Mais l’IA est-elle sans risque ? Découvrez comment l’intelligence artificielle évolue à l’heure actuelle au sein de notre industrie.

Les grands modèles de langage (LLM) ont récemment suscité un engouement majeur à l’échelle mondiale. Quelques mois à peine après le lancement de ChatGPT, son moteur conversationnel basé sur l’intelligence artificielle (IA), OpenAI a attiré plus de 100 millions d’utilisateurs. Cela en fait l’application grand public à la croissance la plus rapide de l’histoire.

Et il n’y a guère de raison de s’étonner. Les LLM peuvent tout faire, comme répondre à des questions, expliquer des sujets complexes, rédiger des scénarios de longs métrages et même écrire du code. Pour cette raison, les gens du monde entier sont à la fois fascinés et préoccupés par les capacités de l’intelligence artificielle.

Même si les LLM ne sont un sujet en vogue que depuis peu, il est important de souligner que la technologie existe depuis longtemps. Bien que des progrès soient en cours, les LLM et autres outils d’IA ouvrent de nouvelles perspectives pour une automatisation plus poussée de diverses tâches. Il est essentiel de bien comprendre les limitations de l’IA et les éventuels risques qui y sont associés.

Explication des termes utilisés

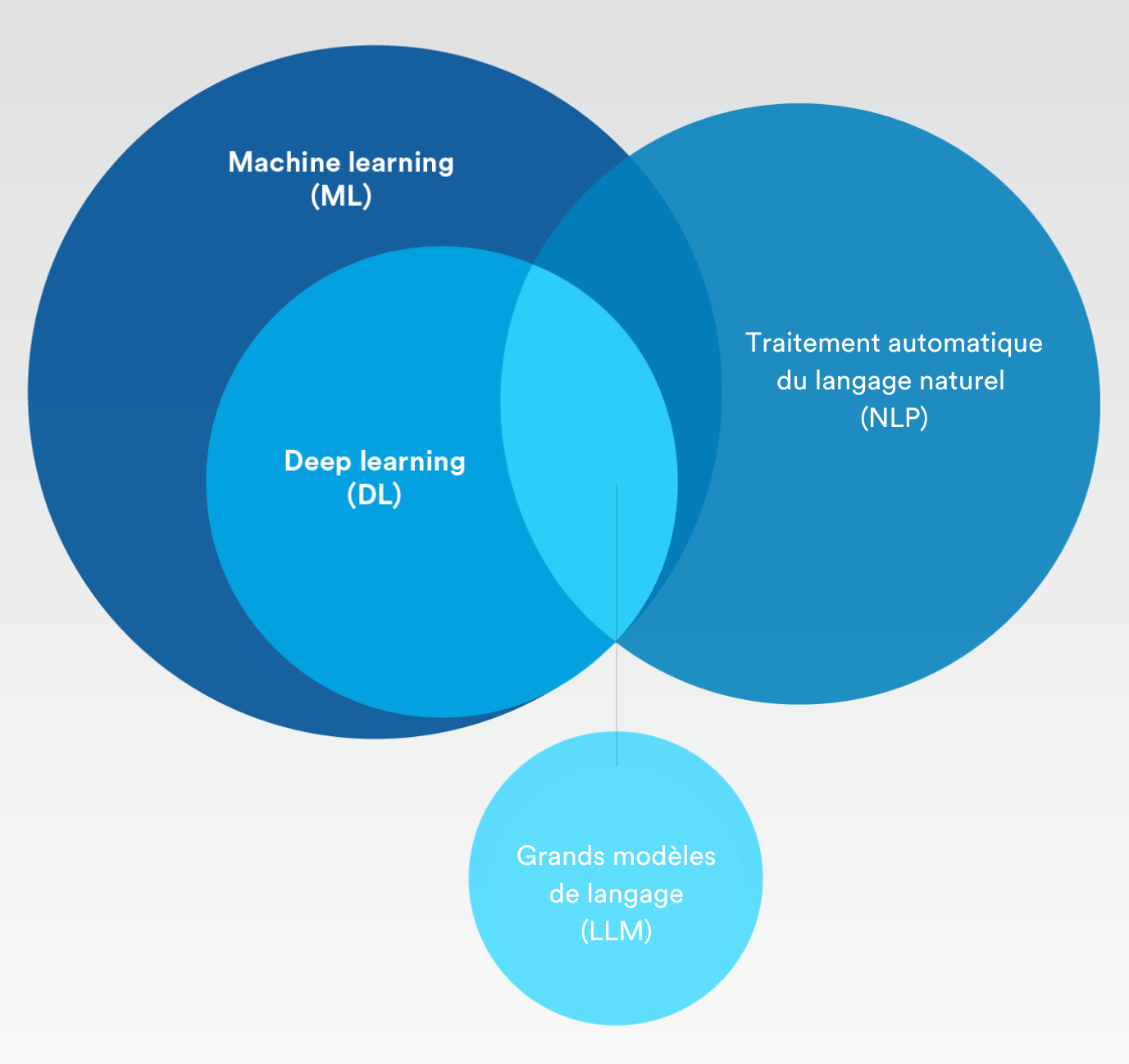

Intelligence artificielle, apprentissage automatique (machine learning), apprentissage en profondeur (deep learning) : quelles sont les différences ? Et comment se positionnent les grands modèles de langage ?

Intelligence artificielle (IA)

Intelligence artificielle

Concept de simulation des processus d’intelligence humaine par des machines. Il s’agit d’outils et de processus qui permettent aux machines d’apprendre par l’expérience et de s’adapter à de nouvelles situations sans programmation explicite. Pour faire simple, le machine learning et le deep learning relèvent tous deux de l’intelligence artificielle.

Machine learning

Intelligence artificielle capable d’apprendre automatiquement avec très peu d’intervention humaine.

Traitement automatique du langage naturel

Processus consistant à utiliser l’intelligence artificielle et le machine learning pour comprendre le langage humain et effectuer automatiquement des tâches répétitives telles que la vérification orthographique, la traduction et la synthèse de document.

Deep learning

Sous-ensemble de l’apprentissage automatique ayant recours à des réseaux de neurones artificiels qui imitent le processus d’apprentissage du cerveau humain.

IA générative

Permet aux utilisateurs de générer rapidement du contenu en se basant sur diverses entrées telles que le texte et la voix, donnant ainsi lieu à une variété de résultats sous forme d’images, de vidéos et d’autres types de données de sécurité.

Grand modèle de langage (LLM)

Algorithme d’intelligence artificielle qui utilise des techniques de deep learning et reçoit d’énormes quantités d’informations provenant d’Internet.

Quelle est la différence entre l’intelligence artificielle (IA) et l’automatisation intelligente (AI) ?

L’IA est-elle vraiment intelligente ? Selon notre PDG, Pierre Racz, « l’IA restera dépendante de la supervision et du jugement humains pendant de nombreuses décennies. L’humain fournit la créativité et l’intuition, et la machine fait le gros du travail. »

C’est la raison pour laquelle le terme d’automatisation intelligente peut décrire de manière plus précise l’IA que nous connaissons aujourd’hui. Par souci de clarté, attardons-nous un instant sur ce point :

L’automatisation consiste à effectuer des tâches, qu’elles soient faciles ou difficiles, sans que personne n’ait besoin de s’en charger. Une fois qu’un processus est créé sous la forme d’un programme, il peut se répéter chaque fois que nécessaire, en produisant toujours le même résultat.

L’automatisation traditionnelle nécessite une définition claire dès le départ. De l’entrée à la sortie, chaque aspect doit être soigneusement planifié et défini par une personne. Une fois défini, le processus automatisé peut être déclenché pour fonctionner comme prévu.

Grâce à l’automatisation intelligente (AI), les machines peuvent prendre en charge des processus simples ou complexes sans qu’ils aient besoin d’être précisément définis. L’AI s’appuie généralement sur le machine learning, comme l’IA générative et le traitement automatique du langage naturel, pour suggérer des façons d’analyser les données ou de prendre des mesures en fonction des données existantes et des habitudes d’utilisation. Cela permet aux humains de disposer des bonnes informations au bon moment et de se concentrer sur les activités principales plutôt que sur les tendances et l’analyse des données.

Voici un bref résumé des différences :

- L’intelligence artificielle est un outil. L’automatisation intelligente implique des résultats.

- L’IA est un moyen, l’AI est une fin.

- Nous combinons l’IA avec d’autres outils tels que l’automatisation pour obtenir un résultat, qui est l’AI.

Quels sont les risques des grands modèles de langage ?

Par le passé, Sam Altman, PDG d’OpenAI, a reconnu des lacunes en matière de partialité qui ont remis en question la sécurité de ChatGPT. Des chercheurs ont également mis en évidence que le fait de demander aux grands modèles linguistiques d’incarner des identités telles qu’une « mauvaise personne » ou même certaines figures historiques multiplie par six les réponses toxiques et nuisibles de la part du modèle d’apprentissage automatique.

Les grands modèles de langage sont-ils sans risque ? Lorsque l’on évalue les risques des LLM, il est important de comprendre que la priorité des grands modèles de langage est de satisfaire l’utilisateur et qu’ils sont entraînés en ce sens. Les LLM utilisent également une méthode d’entraînement d’IA non supervisée pour se nourrir d’une grande quantité de données aléatoires provenant d’Internet. En conséquence, les réponses qu’ils donnent ne sont pas toujours exactes, véridiques ou impartiales. Tout cela devient très dangereux dans un contexte de sécurité.

En effet, cette méthode d’IA non supervisée a ouvert la porte à ce que l’on appelle désormais les « hallucinations de vérité ». Autrement dit, le modèle d’IA génère des réponses qui paraissent plausibles mais qui ne se fondent aucune donnée réelle ou factuelle.

L’utilisation des LLM peut également exposer à de graves risques en matière de confidentialité et de respect de la vie privée. Le modèle peut apprendre à partir de données qui contiennent des informations confidentielles sur des personnes et des entreprises. Et comme chaque « prompt » (requête) de texte est utilisé pour entraîner la version suivante, une personne qui envoie une requête au LLM à propos d’un contenu similaire peut ensuite prendre connaissance de ces informations sensibles via les réponses de l’agent conversationnel (chatbot) de l’IA.

Pensez également à ceux qui se servent de cette technologie d’IA à des fins malveillantes. Imaginez : des individus malveillants, possédant peu ou pas de connaissances en programmation, pourraient demander à un chatbot d’IA d’écrire un script exploitant une vulnérabilité connue, ou demander une liste de moyens de pirater des applications ou des protocoles spécifiques. Malgré le caractère hypothétique de ces exemples, on ne peut s’empêcher de se demander comment ces technologies pourraient être exploitées d’une manière encore inconnue.

Comment les grands modèles de langage évoluent-ils dans le domaine de la sécurité physique ?

Maintenant que les grands modèles de langage font beaucoup parler d’eux, on peut avoir l’impression que l’IA rend tout possible comme par magie. Mais tous les modèles d’IA ne sont pas identiques et n’évoluent pas au même rythme.

Les grands modèles de langage, ainsi que ceux de deep learning et de machine learning, produisent des résultats basés sur la probabilité. Si nous examinons de plus près les grands modèles de langage, leur objectif principal est de fournir la réponse la plus plausible à partir d’un volume massif et aveugle de données. Comme mentionné précédemment, cela peut conduire à de la désinformation ou à des hallucinations.

Dans le domaine de la sécurité physique, les algorithmes de machine learning et de deep learning ne reposent pas sur l’IA générative, qui pourraient inventer des informations. À la place, les modèles d’IA sont conçus pour détecter des modèles et classer les données. Étant donné que ces résultats sont toujours fondés sur des probabilités, l’humain doit rester impliqué et déterminer en bout de ligne ce qui est vrai ou non.

Cela dit, il en va de même pour tous les impacts positifs des LLM. Dans le cadre des applications de sécurité, on peut imaginer un avenir où les opérateurs utiliseraient un modèle de langage d’IA au sein d’une plateforme de sécurité dans le but d’obtenir rapidement des réponses à des questions telles que « combien de personnes se trouvent actuellement au troisième étage ? » ou « combien de badges de visiteur avons-nous délivrés le mois dernier ? » Cette technologie pourrait également être utilisée pour aider les organisations à élaborer des politiques de sécurité ou à peaufiner les détails des protocoles de réponse.

Quelle que soit la manière dont les modèles de langage d’IA sont utilisés, une chose est sûre : les cas d’utilisation en sécurité nécessiteraient des approches permettant de contrôler plus étroitement l’exécution des modèles. Ainsi, même si les LLM suscitent actuellement beaucoup d’enthousiasme, il reste encore beaucoup de travail à accomplir pour les sécuriser et les mettre au service d’applications de sécurité physique.

Comment met-on l’IA en œuvre dans le domaine de la sécurité physique ?

Les LLM sont peut-être au centre de toutes les préoccupations en ce moment, mais l’utilisation de l’IA dans la sécurité physique n’est pas récente. De nombreux usages intéressants de l’IA permettent de renforcer diverses applications.

Voici quelques exemples d’utilisation de l’IA aujourd’hui dans le secteur de la sécurité physique :

Accélération des enquêtes

Examen minutieux des vidéos d’une période donnée afin de repérer toutes les séquences montrant un véhicule de couleur rouge, par exemple.

Automatisation du comptage des personnes

Création d’une alerte lorsque les limites de capacité maximale d’un bâtiment sont atteintes ou que les files d’attente des clients deviennent trop longues, afin d’améliorer le service.

Détection des plaques d’immatriculation des véhicules

Suivi des véhicules recherchés, rationalisation du stationnement des employés dans les bureaux ou surveillance de la circulation dans les villes.

Amélioration de la cybersécurité

Renforcement de la protection antivirus sur les dispositifs grâce au machine learning afin de repérer et de bloquer l’exécution des logiciels malveillants connus et inconnus sur les terminaux.

Security Center SaaS

Adoption de l’automatisation intelligente

Pour la plupart des organisations, la mise en œuvre de l’IA se résume à quelques facteurs déterminants : réaliser des analyses de données à grande échelle et atteindre des niveaux d’automatisation plus élevés. À une époque où le terme « transformation numérique » est sur toutes les lèvres, les organisations cherchent à exploiter leurs investissements en sécurité physique et leurs données pour accroître leur productivité, améliorer leurs opérations et réduire leurs coûts.

L’automatisation peut également aider les organisations à respecter diverses normes et réglementations sectorielles tout en réduisant les coûts associés à la mise en conformité. En effet, le machine learning et le deep learning offrent la possibilité d’automatiser une grande partie du traitement des données et des flux de travail tout en orientant les opérateurs vers des informations pertinentes. Cela leur permet de réagir rapidement aux perturbations des activités et de prendre de meilleures décisions.

Par exemple, l’IA se démocratise grâce à diverses solutions d’analyse vidéo. Les commerçants peuvent aujourd’hui utiliser les analyses de détection du sens de circulation ou du franchissement de seuil pour suivre le comportement des acheteurs. Les enceintes sportives peuvent repérer automatiquement les points de blocage pour fluidifier la circulation des spectateurs pendant les mi-temps. Les organisations peuvent également utiliser l’analyse de comptage des personnes pour suivre les niveaux d’occupation afin de répondre à l’évolution des réglementations en matière de sécurité.

Est-ce trop beau pour être vrai ?

Même avec ces solutions prêtes à l’emploi, de nombreux mythes subsistent quant aux capacités réelles de l’IA. Il est donc important que les professionnels comprennent que la plupart des solutions d’IA dans la sécurité physique ne sont pas universelles. Ce point s’avère particulièrement vrai pour ceux qui cherchent à tirer parti des techniques d’IA pour résoudre des problèmes spécifiques dans les entreprises.

Pour mettre en place l’automatisation des tâches ou obtenir un résultat précis, il faut avant tout évaluer la faisabilité technique de la démarche. Ce processus consiste à identifier les solutions déjà en place, à évaluer les autres technologies qui pourraient être nécessaires, ainsi qu’à identifier les éventuels problèmes de compatibilité à résoudre et autres facteurs environnementaux à prendre en considération.

Une fois la faisabilité évaluée, certaines organisations peuvent se demander si l’investissement en vaut la peine. En effet, même si l’IA constitue un élément clé pour atteindre des niveaux d’automatisation plus élevés dans le secteur de la sécurité physique, cette démarche exige une réflexion et une planification soigneuses pour produire des résultats précis.

En d’autres termes, il est primordial de faire preuve de prudence lorsque l’on explore de nouvelles solutions d’IA, et les résultats promis doivent être soupesés avec l’esprit critique et la diligence appropriés.

Comment peut-on exploiter au mieux l’IA dans le domaine de la sécurité physique à l’heure actuelle ?

Les applications bénéficiant de l’IA évoluent de manière inédite et captivante. Très prometteuses, elles permettent aux organisations d’atteindre des résultats spécifiques qui améliorent la productivité, la sécurité et la sûreté au sein de leur organisation.

L’un des meilleurs moyens de tirer parti des nouvelles avancées de l’IA en matière de sécurité physique consiste à mettre en œuvre une plateforme de sécurité ouverte. Grâce à l’architecture ouverte, les professionnels de la sécurité peuvent librement explorer les applications de l’intelligence artificielle qui apportent une valeur supplémentaire à leurs opérations. À mesure que les solutions d’IA arrivent sur le marché, les dirigeants peuvent essayer ces applications, souvent gratuitement, et sélectionner celles qui correspondent le mieux à leurs objectifs et à leur environnement.

Mais les nouvelles opportunités s’accompagnent également de nouveaux risques. C’est la raison pour laquelle il est tout aussi important de s’associer à des organisations qui privilégient la protection des données, le respect de la vie privée et l’utilisation responsable de l’IA. Non seulement cela contribuera à améliorer la cyber-résilience et à établir la confiance dans votre organisation, mais c’est aussi une façon d’assumer sa responsabilité sociale.

Dans le Rapport IBM intitulé « AI Ethics in Action » (« L’éthique de l’IA en action »), 85 % des consommateurs déclarent qu’il est important que les organisations prennent en compte l’éthique lorsqu’elles utilisent l’IA pour trouver des solutions aux problèmes de la société. Selon 75 % des cadres dirigeants, une bonne gestion de l’éthique en matière d’IA peut démarquer une entreprise de ses concurrents. Et plus de 60 % des cadres dirigeants estiment que l’éthique en matière d’IA contribue à améliorer les performances de leur entreprise en matière de diversité, d’inclusion, de responsabilité sociale et de durabilité.

Une autre étude récente réalisée par Amazon Web Services (AWS) et Morning Consult a révélé que 7 % des personnes interrogées reconnaissent l’importance d’une IA responsable. Si 92 % des entreprises ont déclaré qu’elles prévoyaient d’utiliser des solutions basées sur l’IA d’ici 2028, elles sont près de la moitié (47 %) à prévoir d’augmenter leurs investissements dans l’IA responsable en 2024. Plus d’un tiers (35 %) estime qu’une utilisation irresponsable de l’IA pourrait coûter au moins un million de dollars à leur entreprise ou la mettre en danger.

La vision de Genetec quant au respect de la vie privée et à la gouvernance des données par l’utilisation responsable de l’IA

Étant donné que les algorithmes d’intelligence artificielle peuvent traiter de grandes quantités de données avec rapidité et précision, l’IA devient un outil de plus en plus important pour les solutions de sécurité physique. Mais les évolutions de l’IA amplifient sa capacité à utiliser les informations personnelles d’une manière qui peut porter atteinte à la vie privée.

Les modèles d’IA peuvent également produire par inadvertance des décisions ou des résultats faussés basés sur divers préjugés. Ceci peut influencer les décisions et éventuellement conduire à de la discrimination. Même si l’IA a le pouvoir de révolutionner les méthodes de travail et la prise de décision, elle doit être déployée de manière responsable. Après tout, la confiance est essentielle à la poursuite de la croissance et à la pérennité de notre monde numérique. Et le meilleur moyen d’instaurer la confiance ? Il faut s’associer à des organisations qui privilégient la protection des données, le respect de la vie privée et l’utilisation responsable de l’IA.

C’est pour cette raison que, chez GenetecMC, notre équipe prend l’utilisation responsable de l’IA très au sérieux. Nous avons d’ailleurs mis au point un ensemble de principes directeurs pour la création, l’amélioration et la maintenance de nos modèles d’IA. Ceux-ci reposent sur les trois piliers fondamentaux suivants :

|

Respect de la vie privée et gouvernance des données |

En tant que fournisseur de technologies, nous assumons la responsabilité de la manière dont nous utilisons l’IA dans le développement de nos solutions. Concrètement, nous utilisons uniquement des ensembles de données qui respectent les réglementations pertinentes en matière de protection des données. Dans la mesure du possible, nous anonymisons les ensembles de données et nous nous procurons de manière éthique et sécurisée les données utilisées pour l’entraînement des modèles de machine learning. Nous traitons également les ensembles de données avec le plus grand soin et nous faisons de la protection des données et du respect de la vie privée une priorité dans l’ensemble de nos activités. Par conséquent, nous respectons des mesures strictes en matière d’autorisation et d’authentification afin de nous assurer que seules les bonnes personnes puissent accéder aux données sensibles et aux informations de nos applications basées sur l’IA. Nous nous engageons à fournir à nos clients des outils intégrés qui les aideront à s’adapter à l’évolution des réglementations en matière d’IA.

|

Confiance et sécurité |

Lorsque nous développons et utilisons des modèles d’IA, nous réfléchissons toujours à la manière dont nous pouvons minimiser les préjugés. Notre objectif est de garantir que nos solutions produisent toujours des résultats équilibrés et équitables. Pour y parvenir, nous testons rigoureusement nos modèles d’IA avant de les partager avec nos clients. Nous mettons également tout en œuvre pour améliorer en continu la précision et la fiabilité de nos modèles. Enfin, nous nous efforçons de rendre nos modèles d’IA explicables. Autrement dit, lorsque nos algorithmes d’IA prennent une décision ou produisent un résultat, nous sommes en mesure d’expliquer précisément à nos clients le cheminement suivi pour parvenir à cette conclusion.

|

L’humain toujours impliqué |

Chez Genetec, nous veillons à ce que nos modèles d’IA ne puissent pas prendre seuls des décisions critiques. Nous pensons que l’humain doit toujours être impliqué et avoir le dernier mot. Dans un contexte de sécurité physique, il est essentiel de donner la priorité à une prise de décision centrée sur l’humain. Dans les situations de vie ou de mort, les humains comprennent naturellement les dangers en jeu et les actions nécessaires pour sauver une vie. Les machines ne peuvent tout simplement pas saisir les subtilités des événements de la vie réelle comme un opérateur de sécurité, donc s’appuyer uniquement sur des modèles statistiques ne peut pas être la solution. C’est également la raison pour laquelle nous visons toujours à améliorer les compétences humaines grâce à l'apport de technologies. En d’autres termes, nos systèmes doivent toujours permettre d’améliorer la capacité de jugement de l’être humain.